假如,AI假信息迎来“武器化”的一天?

不管别人是否同意,你只要拿到一张女性穿着衣服的照片,就可以直接把照片放到这款应用当中,按下去处理按钮,半分钟之后一张全裸照片就生成出来。有不少处理之后的效果十分逼真,唯一能证明这些是假照片的是左上角的一个小小的“FAKE”标志。

上面说的这些功能就是上两周发布、并且引起波澜的AI“一键脱衣”应用Deepnude。

从外国网友对一些女明星的红毯照的处理效果来看,部分还是十分逼真的。

显然这些原来的照片中并不包含衣服之下裸体的数据,电脑的处理方式实际上是通过大量对女性全裸照片学习,然后分析用户提供的照片,并且将其中穿衣服的区域改成电脑想象中全裸样子。你甚至可以看做电脑的一份“创作”。

虽然作者已经在生成照片上打上“FAKE”标志,但在很多女网友看来,这种操作依旧不能消除风险:万一别人真的从朋友圈、微博弄到了自己的照片,然后三两下用人工智能生成一批自己的裸体照片,然后被发布到公众空间中,那样一来就会直接形成负面影响。

这已经不是AI生成的假信息第一次引起公众担忧了。

以之前火过一阵的“AI换脸”Deepfakes技术为例,它能直接对视频中的角色进行换脸操作,例如上方这个把佟湘玉变成寡姐的视频。

国外有人在论坛上直接用这种技术,将女明星的脸,替换到色情电影女主角身上,然后再发布出来。神奇女侠盖尔·加朵就一度中招。

当然,单论效果还是奥巴马演讲视频的完成度最高,早在2017年,计算机图形学会议SIGGRAPH上就已经有学者给出了很成熟的技术解决方案,他们成功地将1990年读书时接受采访被录像的“青年”奥巴马,直接用20年之后总统的形象,用电脑和人工智能重新生成一次。

生成出来的奥巴马视频,不仅人物脸部表情十分顺畅,就连眨眼、桥眉头、法令纹、下巴这些细节都做得很完美。

相比图片和视频,文字性的内容也已经沦陷,今年2月,马斯克旗下的OpenAI还曾发布了一个通用语言模型GPT-2,这个模型用800万个网页数据训练而成,整个神经网络拥有15亿个参数,是迄今为止最复杂的神经网络模型。它的目标只有一个,根据给出的一段文字,预测下一个单词。

所以它可以应用到阅读理解、机器翻译、问答、自动摘要等一系列场景中去。不凑巧的是,“假新闻”也是其中一个。由于担心其太能生成假新闻,OpenAI决定不开源这一模型,只给研究者提供简化版的模型。

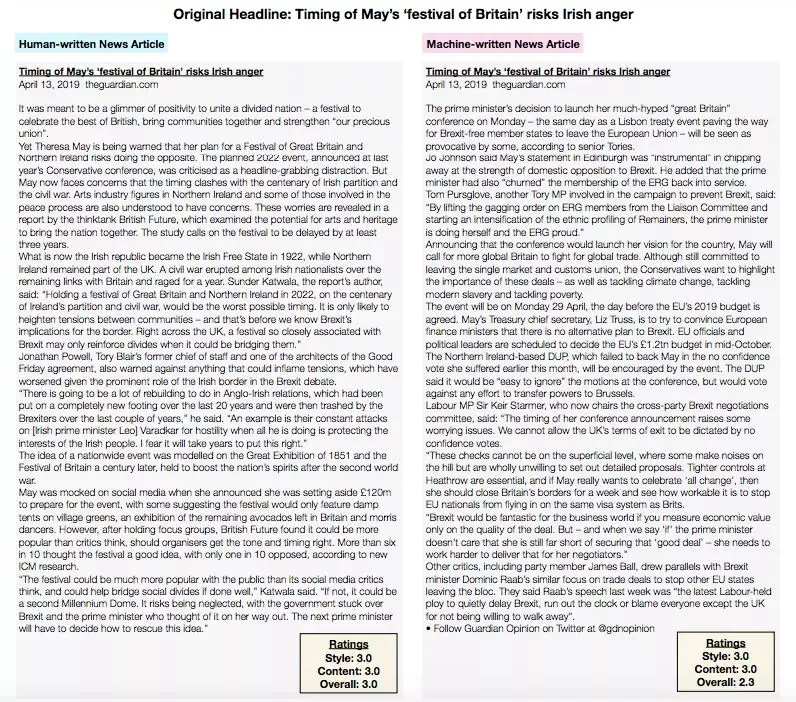

今年6月,华盛顿大学的相关研究者还在GPT-2的基础上开发出了一个检测和生成假新闻的人工智能模型Groved,其根据同一标题进行文章内容创作时,最终文章内容写得甚至比人类还好。

换言之,普通人想要通过文章内容好坏区分是否“机器创作”,已经变得越来越难。

显然,上面提到的这些AI“假信息”远没有发展到终极状态。例如“一键扒光”的Deepnude,其初始训练也只用了10000张裸照,所以实际效果经常出错;又例如DeepFakes,想要实现成功换脸,往往需要普通电脑运行1-2周时间,不然换出来的脸会很模糊;而生成假新闻用的GPT-2虽然已经是规模最大的模型,但也只用了800万网页数据。

假以时日,这些“假信息”必然会变得更真,更难以区分。

当然,就目前来说,部分AI“假信息”还是可以分辨的,例如把图片放大、把视频放慢,寻找其中AI处理的不好的破绽,但像上面提到的文字假新闻、又或者是奥巴马视频演讲,普通人已经完全找不出其中的问题所在了。

那么我们应该如何鉴别一条消息是不是假新闻呢?很可能还是得用AI。

制作出Groved的华盛顿大学研究人员,在生成假新闻之后,反过来用这一套模型对生成的假新闻进行鉴别。他们发现文章内容中字里行间的选取策略其实是可以留下潜在判断依据的,准确率能够达到92%。相比之下,目前主流通用的假新闻判别器(深度预训练语言模型)的准确率也只有73%左右的准确率。

这就好比无论多厉害的高手变换自己的写作风格,文章内容总会有个人的痕迹,那你真的找一个熟悉作者写作风格的人来辨认,的确比较容易认出来。

但自然我们也要担心另外一个问题:未来能够写出这样文章的高手肯定只会越来越多,未来如果想要鉴别一篇新闻是否由“机器创作”,那么就必须让一队熟悉这些高手的逐个确认,假如少了一位审核,最终识别的准确率都会受到极大影响。

在技术之外,人性也是我们必须担心的一个元素。

美军利用运输机往伊拉克播撒信息战传单

上面提到的这些AI“假信息”大部分至今仍处于研究阶段,各种各样的研究人员一边在试探技术的“天花板”、一边也在学术道德的驱使下规避系统风险。就例如OpenAI选择不开源GPT-2完整代码一样。

但并不是所有人都能做到这些。随着越来越多人开始掌握人工智能技术,必然会有人因为商业利益、甚至是国家利益去恶意使用AI假信息这种技术。到那个时候,AI生成的假信息很可能就会像原来世界大战中各方从飞机上投下的小传单一样,专门为动摇人心而存在。

你可以用它们去干扰、误导市场;也可以用它影响军事决策、甚至是影响人民的信心。相比传统的信息商战、信息战威胁,人工智能必然更难对付,后者不仅能在很短的时间内生成大量的内容,同时它在运转起来之后也不需要人过多的干扰,堪称一种完美的信息战武器。

但想要阻碍这样的技术发展也不现实,它的角色更像是战略武器,最终应该形成相互威胁。就看最终在何种情况下,人类会大规模启用这种能力了。

评论